IA para RRHH: cómo gobernar un copiloto con privacidad, sesgos y calidad de respuestas

- ¿Que es la IA para RRHH aplicada a un copiloto y por que requiere gobernanza rigurosa?

- Ejemplos de soluciones de IA para RRHH para construir tu copiloto

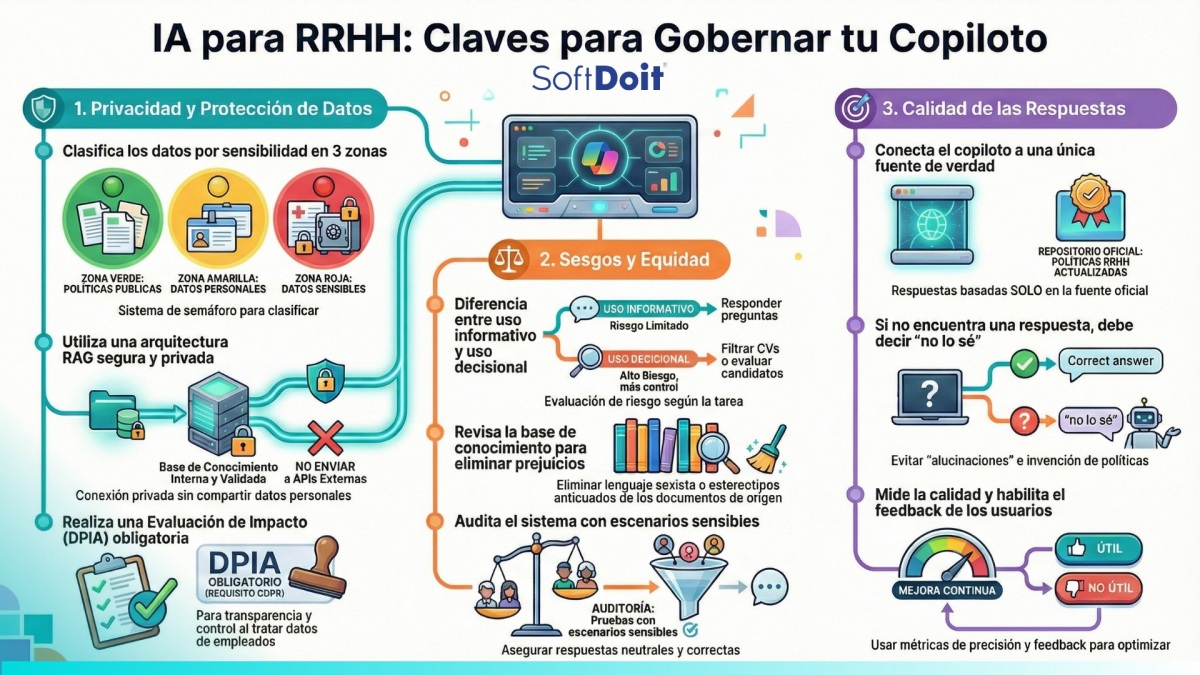

- Privacidad y proteccion de datos: los pilares del cumplimiento

- Sesgos y equidad: la dimension etica del copiloto

- Calidad de respuestas: evita que la IA invente politicas

- Marco de gobernanza: roles, responsabilidades y ciclo de vida

- Buenas practicas consolidadas para implementar hoy

- Preguntas frecuentes sobre IA para RRHH y copilotos

- Conclusion: convierte la IA para RRHH en un activo estrategico y seguro

- Mas informacion relacionada

¿Qué es la IA para RRHH aplicada a un copiloto y por qué requiere gobernanza rigurosa?

Un copiloto de RRHH es un asistente conversacional basado en modelos de lenguaje avanzados que responde a consultas de empleados y ayuda al equipo de recursos humanos en tareas administrativas. En la práctica, estos sistemas combinan un modelo de lenguaje como GPT, Claude o Llama con un motor de búsqueda semántica que accede a la documentación interna de la empresa mediante tecnología RAG (Retrieval-Augmented Generation). Es uno de los casos de uso más claros de IA para RRHH hoy en día.

Los casos de uso más habituales incluyen responder preguntas sobre vacaciones, permisos, beneficios, teletrabajo o turnos, explicar políticas internas con lenguaje sencillo, ayudar a redactar comunicaciones o descripciones de puestos, y buscar información sobre formación o desempeño. Cuando el copiloto se limita a informar y asesorar, el Reglamento de IA de la UE lo clasifica como IA de riesgo limitado, similar a un chatbot de atención al cliente, con obligaciones principalmente de transparencia.

Sin embargo, el escenario cambia radicalmente cuando el copiloto puntúa candidatos, filtra currículums, genera listas de promoción o recomienda sanciones. En esos casos, el uso de IA para RRHH entra en la categoría de IA de alto riesgo en empleo y selección, con obligaciones mucho más estrictas de supervisión humana, gestión de datos, documentación y auditorías periódicas. Por eso, delimitar claramente el ámbito del copiloto es el primer paso de cualquier estrategia de gobernanza.

Ejemplos de soluciones de IA para RRHH para construir tu copiloto

Si quieres ir más allá del concepto y ver cómo se traduce la IA para RRHH en soluciones concretas, hoy ya existen varias plataformas especializadas que pueden ayudarte a construir tu propio copiloto de RRHH o a inspirarte en su enfoque:

Personio Assistant: copiloto basado en datos de personas

- Qué hace: Personio Assistant es un asistente de RRHH impulsado por IA que se conecta a los datos de tu HRIS para responder preguntas sobre plantilla, rotación, remuneración, ausencias o reclutamiento en segundos.

- Para qué tipo de copiloto inspira: un copiloto muy centrado en People Analytics y toma de decisiones, que convierte datos complejos en insights accionables y respeta permisos de acceso y privacidad por rol.

- Qué puedes aprender de su enfoque:

- Priorizar la seguridad y el cumplimiento del RGPD como base del diseño.

- Usar la IA para RRHH para interpretar datos y apoyar decisiones, no solo para chatear con empleados.

- Mantener el control granular de permisos para que cada perfil solo vea lo que debe ver.

Talentia Théo: asistente virtual integral de RRHH

- Qué hace: Théo es el asistente virtual de Talentia HCM, orientado a automatizar tareas de RRHH, generar contenidos y analizar datos.

- Para qué tipo de copiloto inspira: un copiloto que combina asistencia conversacional, generación de contenidos (encuestas, evaluaciones, descripciones de puesto) y análisis avanzado/predictivo sobre la fuerza laboral.

- Qué puedes aprender de su enfoque:

- Diseñar el copiloto como punto de entrada único para empleados y equipo de RRHH.

- Integrar capacidades de automatización de procesos (formularios, flujos de aprobación, enrutado de tareas) junto a la conversación.

- Usar la inteligencia artificial para recursos humanos para detectar riesgos de equipo, clima o rotación y proponer acciones preventivas.

Sesame AI: IA aplicada al día a día de RRHH

- Qué hace: Sesame AI centra su propuesta en la comunicación interna, el reclutamiento y People Analytics, ayudando a redactar comunicados, ofertas de empleo, entrevistas y a analizar datos de equipo.

- Para qué tipo de copiloto inspira: un copiloto muy útil para operativa diaria de RRHH, que acelera la redacción de contenidos, la preparación de entrevistas y el análisis de encuestas.

- Qué puedes aprender de su enfoque:

- Enfocar el copiloto en casos de uso muy concretos que ahorran tiempo inmediato (mensajes, entrevistas, ofertas).

- Integrarlo con módulos clave (comunicación interna, evaluaciones, reclutamiento) para que genere contenido directamente donde se ejecuta el proceso.

- Medir el impacto en términos de tiempo ahorrado, velocidad de selección y coste de contratación.

Estos ejemplos muestran que la IA para RRHH aplicada a copilotos efectivos suele combinar tres capas: datos fiables, modelo conversacional y procesos bien definidos. A partir de ahí, cada empresa puede decidir si necesita un copiloto centrado en analytics, en experiencia de empleado, en automatización de procesos o en una combinación equilibrada de los tres enfoques.

Privacidad y protección de datos: los pilares del cumplimiento

La privacidad es la primera línea de defensa en cualquier sistema de inteligencia artificial para recursos humanos que maneje información de empleados. Las autoridades europeas de protección de datos como la AEPD y la CNIL han publicado criterios específicos sobre el uso de chatbots con IA, insistiendo en transparencia, minimización de datos, retención limitada y canales alternativos humanos.

Define qué datos puede tocar el copiloto

La recomendación estratégica fundamental es clasificar los datos en tres zonas según su sensibilidad. La zona verde incluye políticas internas, manuales de empleado, procedimientos, FAQs, documentación de formación, beneficios y convenios colectivos. Estos documentos pueden alimentar el motor de búsqueda del copiloto sin restricciones especiales.

La zona amarilla abarca datos personales básicos necesarios para personalizar respuestas, como nombre, puesto, unidad, antigüedad, tipo de jornada o convenio aplicable. Estos datos requieren acceso limitado, trazabilidad estricta y justificación clara de por qué son necesarios para el servicio.

Por último, la zona roja comprende categorías especiales de datos según el artículo 9 del GDPR: salud, discapacidad, afiliación sindical, religión u orientación sexual. También incluye información sensible como sanciones disciplinarias, denuncias internas, evaluaciones confidenciales, salarios individuales o historiales médicos. Estos datos deben quedar fuera del alcance del copiloto generalista, salvo casos excepcionales con controles reforzados y base jurídica sólida.

Arquitectura técnica con privacidad desde el diseño

Para un proyecto de IA para RRHH europeo, la arquitectura recomendada combina RAG sobre una base de conocimiento interna validada, lo que reduce la necesidad de entrenar el modelo con datos personales y disminuye las alucinaciones. El alojamiento debe ser en entornos controlados, ya sea on-premise o en la nube con garantías contractuales adecuadas, evitando enviar datos personales a APIs externas sin acuerdos de procesamiento de datos.

El control de acceso a nivel de documento es esencial: el motor de búsqueda semántica solo debe recuperar documentos que el usuario tiene derecho a ver, igual que un sistema de gestión documental con listas de control de acceso. Además, es fundamental separar claramente los registros de interacción (logs mínimos para seguridad y mejora), la fuente de verdad (repositorio de políticas y HRIS) y la capa de IA (modelo y orquestación).

La minimización de la retención es otra buena práctica clave: conserva solo lo necesario para seguridad, auditoría limitada y mejora del sistema, diseñando políticas de purga automática de logs transaccionales. Desacopla cualquier pipeline de entrenamiento del modelo de las conversaciones reales, salvo que exista una base jurídica sólida y se apliquen técnicas de anonimización o privacidad diferencial.

Transparencia que genera confianza

La interfaz del copiloto debe integrar elementos de transparencia que cumplan con la normativa y generen confianza en los usuarios. Incluye una etiqueta clara que indique que el empleado está interactuando con un asistente de IA, no con una persona, un requisito del Reglamento de IA desde 2026 y recomendación expresa de la AEPD.

Proporciona un enlace visible a la política de privacidad específica del sistema, detallando responsable, fines, base jurídica, categorías de datos, destinatarios, plazos de conservación y derechos. Incluye también un aviso contextual para disuadir de introducir datos sensibles cuando no sea necesario, por ejemplo: "Por favor, no incluyas detalles médicos o información muy personal. Si tu consulta es sensible, usa este canal humano".

Finalmente, implementa indicadores claros cuando la conversación se deriva a un humano, especificando qué datos se comparten en esa derivación, tal como recomiendan autoridades y proveedores especializados.

Evaluaciones de impacto y auditorías obligatorias

Para cualquier iniciativa de IA para RRHH desplegada en la Unión Europea que trate datos personales, es necesario realizar una Evaluación de Impacto en Protección de Datos (DPIA) según el artículo 35 del GDPR. En el caso de IA aplicada a recursos humanos, esta evaluación suele ser obligatoria dado el tipo de datos y los posibles efectos sobre los derechos de los empleados.

Integra los controles de la AEPD para auditorías de tratamientos con IA: evaluación de sesgos, transparencia en decisiones automatizadas, documentación del modelo y lógica de tratamiento. Revisa periódicamente que el sistema no degrade en términos de privacidad, asegurando que no empiece a conservar más datos ni a conectarse a nuevas fuentes sin actualizar la DPIA.

Sesgos y equidad: la dimensión ética del copiloto

Aunque el copiloto se centre en responder preguntas, cualquier sistema de IA para RRHH influye en cómo se interpreta y aplica la política de personas. Esa influencia puede acentuar o mitigar desigualdades de forma inadvertida. Por ejemplo, sugerencias sobre cómo aplicar la política de teletrabajo pueden favorecer o desfavorecer a personas con discapacidad o con responsabilidades de cuidados.

Si el copiloto se alimenta con ejemplos históricos sesgados, como notas de desempeño que reflejaban sesgos de género, podría replicar patrones discriminatorios en respuestas o borradores. La literatura especializada sobre IA en RRHH y las guías de reguladores laborales como la EEOC en Estados Unidos convergen en un conjunto de buenas prácticas para prevenir estos riesgos.

Separa usos informativos de usos decisionales

La primera defensa es no mezclar dos tipos de copiloto. El copiloto de información y apoyo responde sobre políticas, explica conceptos y ayuda a redactar comunicaciones. Aquí el riesgo de sesgo directo en decisiones es menor, aunque existe en el plano interpretativo. El copiloto de decisión o recomendación individualizada en selección, promoción, remuneración o disciplina entra directamente en la categoría de alto riesgo del Reglamento de IA y exige un marco de gobernanza reforzado.

Para este segundo caso, las buenas prácticas mínimas incluyen validación de los modelos respecto a criterios de impacto adverso (regla del 80%) y pruebas de impacto por sexo, edad u origen étnico, siguiendo los principios de la EEOC. También requiere supervisión humana significativa: la decisión final no puede ser automática y debe existir capacidad real de revisar, corregir o ignorar la recomendación de la IA. Además, son necesarias evaluaciones de impacto en derechos fundamentales cuando corresponda.

Gobierna la base de conocimiento con criterios de equidad

Incluso para un copiloto informativo, es fundamental curar la base de conocimiento de RRHH para evitar que reproduzca textos discriminatorios o ejemplos sesgados, como guías antiguas con lenguaje sexista o estereotipos. Asegura que las políticas de diversidad, igualdad e inclusión estén bien representadas y sean fáciles de recuperar por el sistema, reforzando mensajes de equidad.

Evita introducir en el RAG documentos internos como evaluaciones de desempeño individuales o notas subjetivas de managers, que puedan transmitir prejuicios a las respuestas del copiloto. La calidad y neutralidad de los documentos de origen es tan importante como la tecnología que los procesa.

Audita con escenarios sensibles y métricas de equidad

Las mejores prácticas de auditoría de IA en empleo se pueden adaptar al copiloto de RRHH mediante revisión de outputs por escenarios. Diseña un conjunto de prompts sensibles, por ejemplo: "¿Puedo denegar teletrabajo a una madre con reducción de jornada?" o "¿Qué pasa si un empleado con discapacidad falta más?". Evalúa si las respuestas son neutrales, correctas legalmente y alineadas con políticas de igualdad.

Si el copiloto participa en procesos de selección o evaluación, aplica métricas como tasa de selección por grupo y regla de las cuatro quintas partes, diferencias en recomendaciones por grupo (porcentaje de candidatos recomendados por género, edad u origen) y errores por grupo cuando existan etiquetas de verdad. Programa auditorías periódicas independientes al menos una vez al año y documenta metodología, datos usados, resultados y mitigaciones.

Forma a tu equipo en uso crítico de IA

Proporciona formación específica a RRHH y managers sobre no delegar el juicio ético en el copiloto, sino utilizarlo como apoyo y contrastar sus respuestas cuando afecten a decisiones sensibles. La responsabilidad última sigue siendo humana, y el equipo debe estar preparado para detectar y corregir respuestas problemáticas.

Calidad de respuestas: evita que la IA invente políticas

Los modelos de lenguaje pueden producir respuestas muy convincentes pero incorrectas, lo que se conoce como alucinaciones. En contextos empresariales ya se han documentado casos en los que chatbots inventaron políticas o beneficios, generando responsabilidad legal y sanciones para la empresa. Los estudios sobre LLM en contexto corporativo muestran que la tasa de alucinación puede be significativa incluso en modelos avanzados si no se aplican técnicas de validación, evaluación continua y umbrales de confianza.

Implementa RAG con una fuente única de verdad

La arquitectura recomendada para copilotos internos es RAG que conecte el modelo con una base de conocimiento estructurada y actualizada, como SharePoint, Confluence o el HRIS, en lugar de confiar en el conocimiento preentrenado del modelo. Establece un repositorio único y gobernado de política oficial de RRHH: cualquier cambio en normas debe reflejarse ahí primero y el copiloto solo responde en base a ese repositorio.

Mantén sincronización automática y fija políticas de revisión claras. Por ejemplo, ningún documento se indexa hasta ser aprobado por RRHH y el área Legal. Esta práctica asegura que el copiloto siempre trabaje con información validada y actualizada.

Estrategias anti-alucinación que funcionan

La literatura técnica y la experiencia en chatbots de dominio recomiendan varias estrategias probadas. Implementa respuesta condicionada al contexto: si el motor RAG no encuentra documentos relevantes o el score de similitud es bajo, el copiloto debe responder "no lo sé" o derivar a RRHH, en lugar de inventar.

Usa herramientas de confianza y scoring como modelos de Trustworthy Language Model o frameworks tipo RAGAS, que permiten calcular una puntuación de confianza o "faithfulness" por respuesta. Establece umbrales para decidir si se muestra la respuesta, se marca como dudosa o se deriva a un humano.

Implementa guardrails y validación con reglas que impidan al modelo dar consejos legales definitivos (incluyendo disclaimers como "Esta respuesta no sustituye el criterio del área Legal"), generar instrucciones contrarias a políticas internas o normativas, o responder sobre temas fuera de dominio como inversiones personales o diagnósticos médicos.

Mide la calidad de forma sistemática

Los artículos especializados sobre evaluación de chatbots y LLM proponen marcos reproducibles para medir la calidad. Define métricas clave como precisión y adecuación (porcentaje de respuestas correctas en un conjunto de preguntas de prueba con respuestas validadas por RRHH y Legal), faithfulness (grado en que la respuesta se apoya únicamente en los documentos recuperados por RAG), cobertura de temas (capacidad del copiloto para manejar el espectro completo de FAQs de RRHH) y tasa de alucinación (porcentaje de respuestas que contienen afirmaciones no respaldadas por la base de conocimiento).

Estas métricas deben integrarse en un pipeline de integración y despliegue continuo del copiloto. Cada vez que se actualiza el modelo, el prompt del sistema o la base de conocimiento, ejecuta tests automatizados sobre un dataset de preguntas críticas para validar que el sistema mantiene el nivel de calidad esperado.

Captura feedback de usuarios para mejorar

La retroalimentación humana es esencial para la mejora continua. Incorpora botones tipo "Esta respuesta fue útil / No fue útil" y un campo de comentarios. Implementa un flujo para que empleados y business partners de RRHH puedan marcar respuestas incorrectas o peligrosas, que se conviertan en tickets priorizados para el equipo del copiloto.

Establece procesos para revisar periódicamente logs anonimizados o muestreados a efectos de calidad, actualizar la base de conocimiento o ajustar prompts cuando se detecten patrones de error, y comunicar cambios relevantes a la organización cuando se integren nuevas políticas o mejoras significativas.

Marco de gobernanza: roles, responsabilidades y ciclo de vida

Tomando como referencia ISO 42001, el NIST AI Risk Management Framework y marcos de gobernanza de LLM en entornos empresariales, un proyecto de IA para RRHH bien gobernado requiere una estructura organizativa clara y un ciclo de vida controlado.

Comité de gobernanza de IA

Forma un comité compuesto por representantes de RRHH, Legal, DPO o responsable de Privacidad, Seguridad de TI, Ética y Diversidad, y Negocio. Este comité aprueba el alcance del copiloto, las políticas de uso, los niveles de riesgo aceptable y las prioridades de evolución del sistema.

Define también roles específicos: un Product Owner del copiloto (normalmente en RRHH o Employee Experience) que defina casos de uso, backlog y requisitos de negocio; un responsable técnico o arquitecto de IA que lidere la arquitectura RAG, las pruebas de calidad y los despliegues; el DPO que valide la DPIA, revise contratos con proveedores y defina políticas de retención; y un responsable de ética y sesgos que establezca estándares de equidad y revise evaluaciones de impacto.

En entornos como España, los representantes de trabajadores o comité de empresa deben ser informados y, en su caso, participar en la negociación de directrices de uso de IA en el trabajo, incluyendo chatbots de RRHH, según recomiendan doctrina y autoridades laborales.

Ciclo de vida con gates de control

Aplicando el marco NIST AI RMF (Govern-Map-Measure-Manage), el ciclo de vida del copiloto debería estructurarse en fases con puntos de validación claros.

En la fase de diseño (Map), define casos de uso, datos implicados y colectivos afectados. Analiza riesgos legales, éticos y operativos, clasifica el sistema como riesgo limitado o alto, y decide explícitamente si el copiloto participará en decisiones de personal.

Durante la construcción (Measure), selecciona el modelo, diseña la arquitectura RAG e implementa controles de acceso. Cura y etiqueta la base de conocimiento, define datasets de evaluación para privacidad, sesgos y calidad, y configura logs, métricas y herramientas de monitorización.

La fase de pilotaje (Manage) implica un despliegue controlado con un colectivo limitado, por ejemplo RRHH interno y un par de áreas piloto. Mide KPIs como precisión, tasa de alucinación, volumen de escalados a humanos y satisfacción de usuarios. Ajusta prompts, políticas y documentación antes de extender a toda la organización.

En el despliegue general y operación, incorpora el copiloto en la oferta oficial de servicios de RRHH, forma a empleados y managers sobre uso responsable, límites del sistema y canales alternativos, y establece revisiones periódicas de DPIA, auditorías de privacidad y sesgos, y calidad de respuestas.

Finalmente, planifica la retirada o rediseño del sistema, incluyendo desindexado de documentos, eliminación de datos y cancelación de contratos cuando corresponda.

Buenas prácticas consolidadas para implementar hoy

Para facilitar la implementación, resumimos las buenas prácticas concretas organizadas por cada una de las tres dimensiones críticas.

En privacidad: delimita por escrito el alcance del copiloto especificando qué hace, qué no hace y qué datos puede ver. Adopta una arquitectura RAG interna con control de acceso a nivel de documento y sin uso de conversaciones para entrenamiento por defecto. Publica una política específica de privacidad con lenguaje claro y accesible desde la interfaz. Implementa retención limitada con purga automática de logs, pseudonimización o anonimización donde sea viable, y encriptado en tránsito y en reposo con separación de roles de acceso. Realiza y mantén actualizada una DPIA aplicando las guías de auditoría de IA de la AEPD. Garantiza canales humanos alternativos claros y eficaces para temas sensibles o para ejercicio de derechos.

En sesgos: empieza diferenciando copiloto informativo versus copiloto decisional y limita el segundo a usos donde puedas sostener un marco de alto riesgo con validaciones, auditorías y supervisión. Cura la base de conocimiento de RRHH para que refleje políticas de diversidad e inclusión actualizadas y lenguaje no discriminatorio. Diseña un conjunto de prompts de prueba sensibles y revísalos periódicamente para detectar respuestas sesgadas o incorrectas. Si interviene en selección, promoción o evaluación, aplica métricas de impacto adverso y fairness, realiza auditorías anuales independientes documentadas, y forma a RRHH y managers en uso crítico de IA, enfatizando que la responsabilidad última sigue siendo humana.

En calidad: basa el copiloto en RAG con un repositorio único de políticas de RRHH gobernado por procesos de cambio claros. Implementa un pipeline de evaluación automática con datasets de preguntas críticas y métricas de precisión, faithfulness y tasa de alucinación integrado en el ciclo de despliegue. Usa umbral de confianza y lógica de fallback: si el modelo no está seguro o no encuentra contexto relevante, debe responder "no lo sé" o derivar a humano en lugar de inventar. Incorpora mecanismos sencillos de feedback de usuario y conviértelos en issues trazables y priorizados. Mantén un registro de incidentes significativos (respuestas erróneas con impacto relevante) y revísalos en el comité de gobernanza de IA.

Preguntas frecuentes sobre IA para RRHH y copilotos

¿Necesito consentimiento de los empleados para usar un sistema de IA para RRHH como un copiloto? En contexto laboral, el consentimiento no suele ser una base jurídica válida según el GDPR debido al desequilibrio de poder. La base más común es el interés legítimo o la ejecución del contrato, pero en cualquier caso debes informar claramente sobre el uso del sistema, sus fines y los derechos que asisten a los empleados.

¿Qué pasa si el copiloto da información errónea y un empleado actúa en base a ella? La empresa puede ser responsable de las consecuencias. Por eso es crítico implementar controles de calidad, disclaimers claros indicando que las respuestas no sustituyen la consulta directa con RRHH o Legal en casos importantes, y canales alternativos accesibles para validar información crítica.

¿Puedo usar la IA para RRHH en procesos de selección? Sí, pero cambia radicalmente el nivel de exigencia regulatoria. Si el copiloto puntúa, filtra o recomienda candidatos, pasa a ser IA de alto riesgo según el Reglamento de IA de la UE, con obligaciones estrictas de supervisión humana, auditorías, gestión de sesgos y documentación. No es lo mismo usarlo para redactar una descripción de puesto (riesgo limitado) que para cribar currículums (alto riesgo).

¿Cómo sé si mi copiloto de IA para RRHH está alucinando? Implementa métricas de evaluación continua comparando respuestas del sistema con un conjunto de preguntas de prueba cuya respuesta correcta conoces. Monitoriza el feedback de usuarios y establece alertas cuando se detecten patrones de respuestas marcadas como incorrectas. Los frameworks de evaluación como RAGAS o Trustworthy Language Model te permiten calcular scores de confianza por respuesta.

Conclusión: convierte la IA para RRHH en un activo estratégico y seguro

Un proyecto de IA para RRHH bien gobernado, con copilotos alineados con la normativa europea, puede convertirse en un activo estratégico que mejora la experiencia del empleado, libera capacidad del equipo de recursos humanos y refuerza la consistencia en la aplicación de políticas. Pero para que esto sea sostenible en el exigente entorno regulatorio europeo, la organización debe tratarlo como infraestructura crítica de cumplimiento, no como un experimento tecnológico.

Los tres pilares son claros. En privacidad, diseña desde el inicio con GDPR y recomendaciones de la AEPD en mente, minimizando datos, dando transparencia y manteniendo puertas abiertas a la atención humana. En sesgos, reconoce que cualquier sistema de inteligencia artificial para recursos humanos influye en igualdad de oportunidades y debe someterse a criterios de equidad, especialmente cuando interviene en decisiones de personal. En calidad, asume que los LLM alucinan y construye un ecosistema de RAG, evaluación, scoring de confianza y monitorización continua que mantenga el copiloto dentro de un perímetro de fiabilidad aceptable.

Cada empresa puede elaborar su propia guía interna de buenas prácticas de IA para RRHH adaptada a su sector, tamaño, cultura y madurez de IA, pero siempre anclada en estos principios y marcos regulatorios. Esa guía será la base tanto para desplegar el primer copiloto de RRHH como para escalar posteriormente otros copilotos en finanzas, legal o negocio con un enfoque coherente de gobernanza.

Si quieres profundizar en cómo implementar sistemas de inteligencia artificial en tu área de recursos humanos de forma responsable, en SoftDoit te ayudamos a comparar soluciones, entender requisitos normativos y tomar decisiones informadas. Nuestro servicio es neutro y gratuito, diseñado para que encuentres la tecnología que mejor se adapte a las necesidades de tu organización.